目次

はじめに:MLモデルデプロイメントの課題

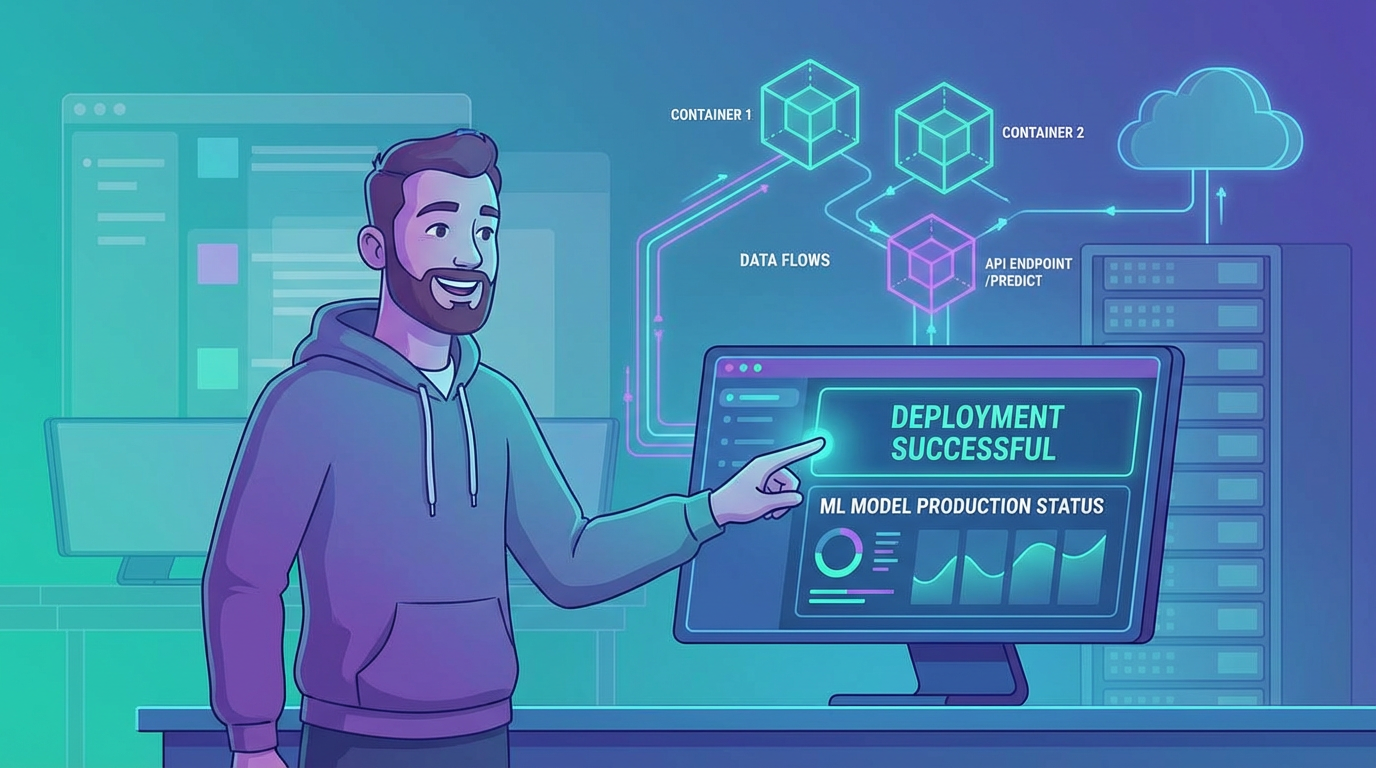

機械学習モデルを本番環境にデプロイすることは、多くのデータサイエンティストにとって大きな壁です。2025年の現在でも、モデルの本番化は複雑で時間がかかります。

BentoMLは、機械学習モデルのサービング専用フレームワークとして、デプロイメントを劇的に簡素化します。

本記事では、BentoMLを使った本格的なMLモデルデプロイメント手法を解説します。

BentoMLの特徴

BentoMLは、MLモデルをAPI化し、スケーラブルにデプロイするためのフレームワークです。

主な特徴

- フレームワーク非依存: scikit-learn、PyTorch、TensorFlow等に対応

- 高パフォーマンス: 最適化された推論エンジン

- スケーラブル: Kubernetes、Docker対応

- バージョン管理: モデルの履歴管理

対応フレームワーク

- scikit-learn: 機械学習モデル

- PyTorch: ディープラーニング

- TensorFlow/Keras: ニューラルネットワーク

- XGBoost/LightGBM: 勾配ブースティング

- ONNX: 標準フォーマット

基本的な使い方

インストール

pip install bentomlモデルの保存

import bentoml

from sklearn.ensemble import RandomForestClassifier

# モデルのトレーニング

model = RandomForestClassifier()

model.fit(X_train, y_train)

# BentoMLに保存

bentoml.sklearn.save_model("iris_classifier", model)サービスの定義

import bentoml

from bentoml.io import JSON, NumpyNdarray

iris_runner = bentoml.sklearn.get("iris_classifier:latest").to_runner()

svc = bentoml.Service("iris_classifier", runners=[iris_runner])

@svc.api(input=NumpyNdarray(), output=JSON())

def predict(input_data):

result = iris_runner.predict.run(input_data)

return {"prediction": result.tolist()}ローカルでのテスト

bentoml serve service:svc --reload本番デプロイ

Dockerコンテナ化

# Dockerイメージのビルド

bentoml containerize iris_classifier:latest

# コンテナの実行

docker run -p 3000:3000 iris_classifier:latestKubernetes展開

# Kubernetesマニフェストの生成

bentoml generate kubernetes iris_classifier:latest

# デプロイ

kubectl apply -f deployment.yamlクラウドデプロイ

BentoMLは主要クラウドプロバイダーに対応:

- AWS: ECS、EKS、Lambda

- GCP: Cloud Run、GKE

- Azure: AKS、Container Instances

高度な機能

バッチ推論

複数のリクエストをまとめて処理:

@svc.api(

input=NumpyNdarray(),

output=JSON(),

batch=True

)

async def predict_batch(input_data):

results = await iris_runner.predict.async_run(input_data)

return resultsモデルバージョン管理

# モデル一覧

bentoml models list

# 特定バージョンの取得

bentoml models get iris_classifier:version_1パフォーマンスモニタリング

Prometheus、Grafanaとの統合により、本番環境での性能監視が可能です。

まとめ:2025年のMLデプロイメント

BentoMLは、機械学習モデルの本番デプロイを簡素化する強力なフレームワークです。

重要なポイント:

- 簡単なAPI化: コードを書くだけでREST APIに

- フレームワーク非依存: 主要ML/DLフレームワークに対応

- 本番対応: スケーラブルで堅牢なデプロイ

- バージョン管理: モデルの履歴管理とロールバック

- クラウド対応: 主要クラウドへの簡単デプロイ

BentoMLを活用することで、データサイエンティストはモデル開発に集中し、デプロイの複雑さから解放されます。

詳しくはBentoML公式ドキュメントをご確認ください。

コメント