はじめに:データパイプラインの複雑化

データパイプラインは現代のビジネスにおいて不可欠ですが、複雑化と規模拡大により管理が困難になっています。2025年の現在、ワークフロー自動化は、データエンジニアリングの成否を分ける重要な要素です。

Apache Airflow 2.9は、データオーケストレーションのデファクトスタンダードとして進化を続けており、最新版では使いやすさと堅牢性が大幅に向上しました。

本記事では、Airflow 2.9の新機能と2025年のワークフロー自動化のベストプラクティスを解説します。

Apache Airflow 2.9の主要な新機能

Airflow 2.9では、ユーザビリティ、パフォーマンス、セキュリティが強化されました。

UI/UXの大幅改善

Webインターフェースが刷新され、より直感的な操作が可能になりました。DAG(Directed Acyclic Graph)の可視化が改善され、複雑なワークフローも一目で理解できます。

主な改善点:

- ダッシュボードの高速化: ページロード時間が50%削減

- DAGグラフの改善: ズーム、パン操作の最適化

- 検索機能の強化: 高速な全文検索

- カラースキーム: ダークモード対応

Dynamic Task Mappingの強化

動的タスクマッピングにより、実行時にタスク数を動的に決定できます。並列処理が必要なデータセットを柔軟に扱えるようになりました。

動的マッピングの利点:

- 柔軟な並列実行: データ量に応じて自動スケール

- コードの簡潔化: ループ不要で直感的

- リソース効率: 必要なタスクのみ実行

データ駆動型スケジューリング

Dataset-Driven Schedulingにより、データの準備状況に基づいてワークフローを自動トリガーできます。時間ベースのスケジューリングだけでなく、データの更新イベントに反応します。

これにより、データの鮮度を保ちながら無駄な実行を削減できます。

DAG(Directed Acyclic Graph)の基本

DAGの構造

Airflowでは、DAGとしてワークフローを定義します。各タスクは依存関係でつながれ、順序が保証されます。

基本的なDAG定義:

from airflow import DAG

from airflow.operators.python import PythonOperator

from datetime import datetime, timedelta

# デフォルト引数

default_args = {

'owner': 'data-team',

'retries': 3,

'retry_delay': timedelta(minutes=5),

}

# DAG定義

with DAG(

'data_pipeline_2025',

default_args=default_args,

description='2025年のデータパイプライン',

schedule='@daily',

start_date=datetime(2025, 1, 1),

catchup=False,

tags=['production', 'etl'],

) as dag:

# タスク定義

extract_task = PythonOperator(

task_id='extract_data',

python_callable=extract_function,

)

transform_task = PythonOperator(

task_id='transform_data',

python_callable=transform_function,

)

load_task = PythonOperator(

task_id='load_data',

python_callable=load_function,

)

# 依存関係の定義

extract_task >> transform_task >> load_taskタスク間の依存関係

複雑な依存関係も柔軟に定義できます:

- 順次実行:

task1 >> task2 >> task3 - 並列実行:

task1 >> [task2, task3] >> task4 - 条件分岐: BranchOperatorで条件により分岐

実践的なユースケース

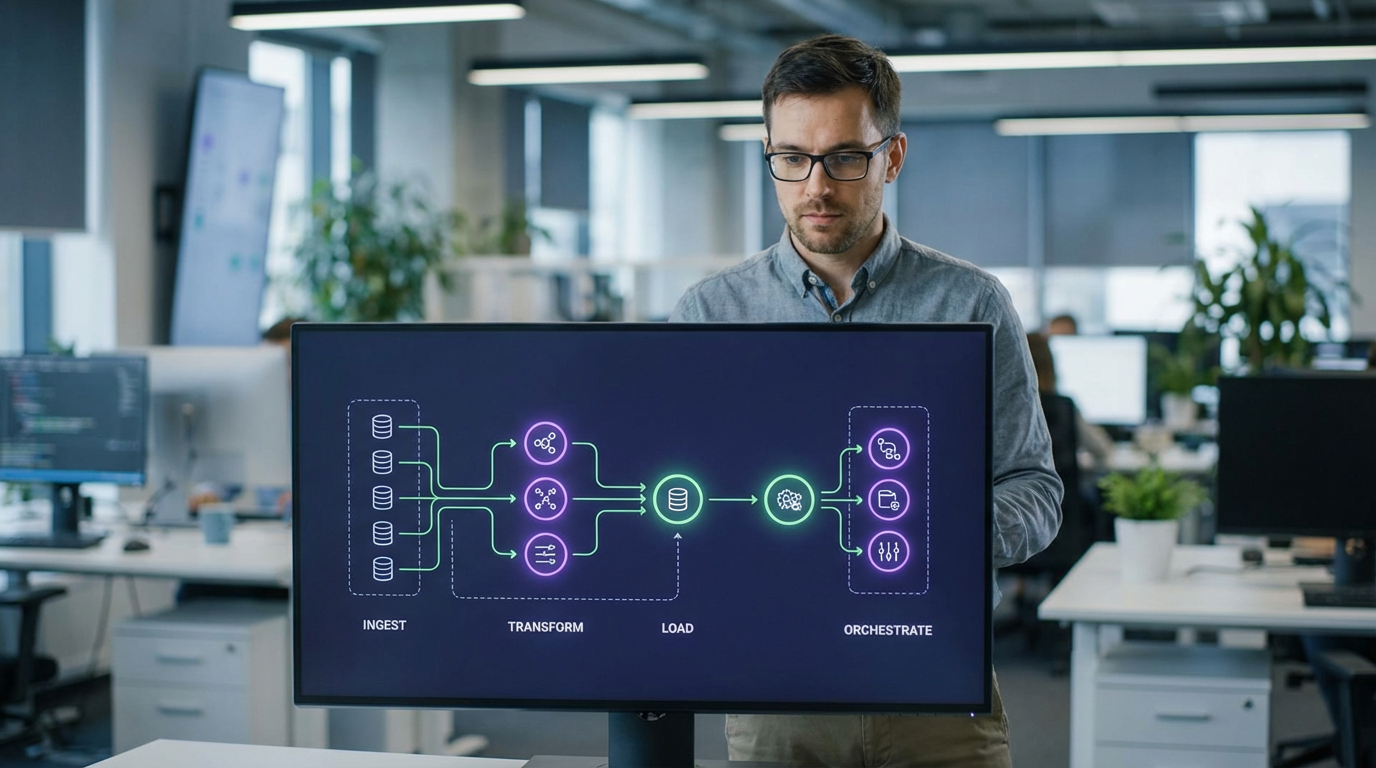

ETLパイプラインの構築

データの抽出、変換、ロードを自動化します。

主要な機能:

- データ抽出: API、データベース、ファイルから取得

- データ変換: クレンジング、集計、エンリッチメント

- データロード: DWH、データレイクへの格納

- エラーハンドリング: 自動リトライと通知

機械学習パイプライン

モデルのトレーニングからデプロイまでを自動化します:

- データ準備: 特徴量エンジニアリング

- モデルトレーニング: 並列ハイパーパラメータチューニング

- モデル評価: 性能メトリクスの計算

- モデルデプロイ: 本番環境への自動デプロイ

- モニタリング: 性能劣化の検出

レポート自動生成

定期的なビジネスレポートを自動生成します:

- データ集計: 日次、週次、月次の集計

- 可視化: グラフ、ダッシュボードの生成

- 配信: メール、Slackへの自動送信

オペレーター(Operator)の活用

標準オペレーター

Airflowは豊富な標準オペレーターを提供します:

- PythonOperator: Python関数を実行

- BashOperator: シェルコマンドを実行

- EmailOperator: メール送信

- SQLOperator: SQL実行

- HttpOperator: HTTP APIコール

プロバイダーパッケージ

外部サービスとの統合:

- AWS: S3、Redshift、EMR等

- GCP: BigQuery、GCS、Dataflow等

- Azure: Blob Storage、Synapse等

- Snowflake: データウェアハウス連携

- Databricks: Spark処理

カスタムオペレーター

独自のオペレーターも簡単に作成できます。

スケーリングと運用

Executorの選択

ワークロードに応じて実行エンジンを選択します:

- SequentialExecutor: 開発環境向け(単一プロセス)

- LocalExecutor: 小規模本番(マルチプロセス)

- CeleryExecutor: 大規模分散環境

- KubernetesExecutor: コンテナベース動的スケール

監視とアラート

運用監視の重要性:

- メトリクス収集: Prometheus、Grafana統合

- ログ管理: 集中ログ管理システムと連携

- アラート: タスク失敗時の自動通知

- SLA監視: 処理時間の監視

セキュリティとアクセス制御

Airflow 2.9では、エンタープライズレベルのセキュリティ機能を提供:

- RBAC: ロールベースアクセス制御

- 認証: LDAP、OAuth、SAMLサポート

- 暗号化: 接続情報の暗号化保存

- 監査ログ: 全操作の記録

まとめ:2025年のワークフロー自動化

Apache Airflow 2.9は、データパイプラインを効率的に管理するための包括的なプラットフォームです。

2025年のデータオーケストレーションで重要なポイント:

- 可視化: 複雑なワークフローの理解が容易

- 自動化: 手動作業の排除と信頼性向上

- スケーラビリティ: 小規模から大規模まで対応

- 拡張性: 豊富なプロバイダーとカスタマイズ性

- 運用性: 監視、アラート、ログ管理の統合

Airflowを活用することで、データエンジニアリングチームの生産性を大幅に向上できます。

詳しくはApache Airflow公式ドキュメントをご確認ください。

コメント